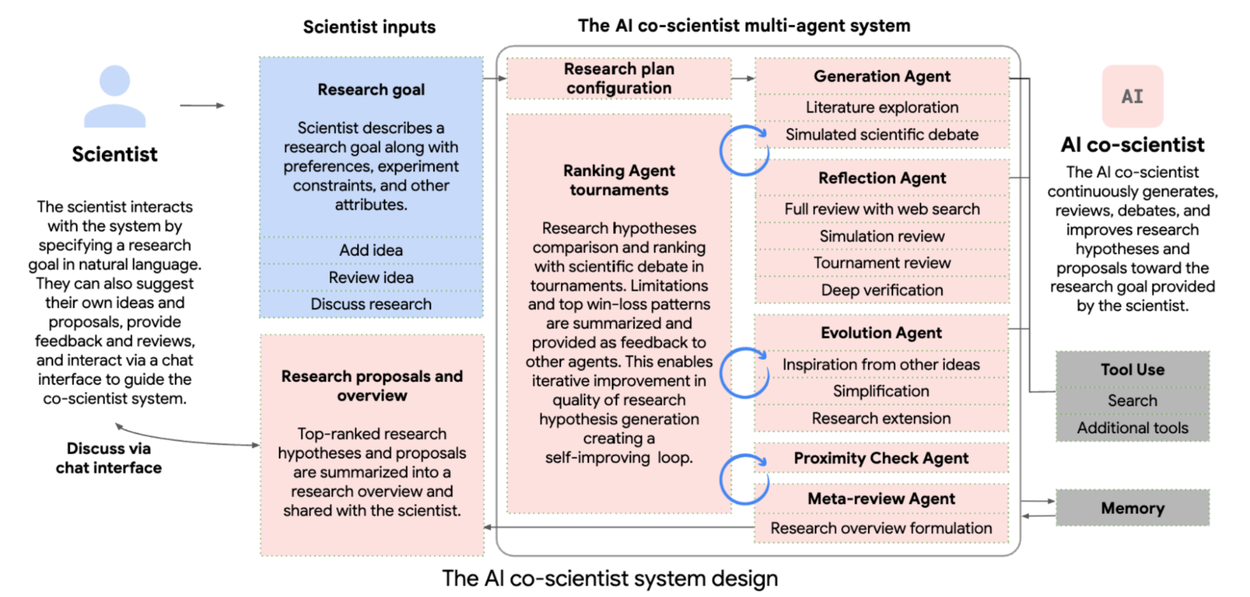

In der wissenschaftlichen Forschung kombinieren Wissenschaftler Kreativität und Fachwissen, um neuartige Forschungsrichtungen zu entwickeln. Angesichts des schnellen Wachstums wissenschaftlicher Publikationen ist es jedoch eine Herausforderung, Erkenntnisse aus unbekannten Bereichen zu integrieren. Der AI Co-Scientist von Google wurde entwickelt, um diese Herausforderungen zu bewältigen und als kollaboratives Werkzeug für Wissenschaftler zu fungieren. Das System nutzt spezialisierte Agenten, um innovative Forschungshypothesen zu generieren, Forschungsüberblicke zu erstellen und experimentelle Protokolle zu entwickeln1Accelerating scientific breakthroughs with an AI co-scientist2Towards an AI co-scientist.

Der AI Co-Scientist analysiert Forschungsziele, verwaltet Ressourcen und verbessert kontinuierlich seine wissenschaftlichen Argumente durch automatisiertes Feedback. Die Leistung des Systems wird durch eine Elo-Auto-Bewertung gemessen, die einen positiven Zusammenhang zwischen höheren Elo-Bewertungen und der Qualität der Ergebnisse zeigt.

In praktischen Anwendungen, wie der Medikamentenumwidmung und der Entdeckung neuer Behandlungsmethoden, hat das System vielversprechende Ergebnisse erzielt. So wurden beispielsweise neuartige Medikamente zur Behandlung von akuter myeloischer Leukämie identifiziert und deren Wirksamkeit experimentell bestätigt.

Der AI Co-Scientist zeigt ein großes Potenzial zur Unterstützung von Wissenschaftlern bei der Beschleunigung von Entdeckungen und könnte die Art und Weise, wie Forschung betrieben wird, erheblich verändern. Um die Stärken und Grenzen des Systems weiter zu evaluieren, wird ein Trusted Tester-Programm für Forschungsorganisationen eingerichtet.

Bereiche, in denen eine Elo-Bewertung für KI-Agenten sinnvoll sein kann:

- Leistungsbewertung: Die Elo-Bewertung könnte genutzt werden, um die Leistung der KI-Agenten bei der Generierung von Hypothesen oder Lösungen zu bewerten. Höhere Elo-Werte würden darauf hinweisen, dass ein Agent erfolgreichere oder qualitativ hochwertigere Ergebnisse erzielt hat.

- Vergleich von Modellen: Durch die Verwendung der Elo-Bewertung könnte man verschiedene KI-Modelle oder ‑Agenten miteinander vergleichen, um festzustellen, welches Modell besser in der Lage ist, relevante und innovative Forschungsergebnisse zu liefern.

- Adaptive Verbesserung: Die Elo-Bewertung könnte auch als Feedback-Mechanismus dienen, der den Agenten hilft, ihre Strategien und Ansätze zu verbessern. Basierend auf den Bewertungen könnten die Agenten lernen, welche Hypothesen oder Methoden erfolgreicher sind und ihre Vorgehensweise entsprechend anpassen.

- Selbstkritik und Optimierung: Die Agenten könnten durch den Vergleich ihrer Elo-Wertungen in einem Wettbewerb miteinander lernen und sich selbstkritisch hinterfragen, was zu einer kontinuierlichen Optimierung ihrer Leistung führen könnte.

- Qualitätssicherung: Eine Elo-Bewertung könnte als Teil eines Qualitätssicherungssystems fungieren, um sicherzustellen, dass die von den Agenten generierten Hypothesen und Vorschläge auf einem bestimmten Niveau liegen und potenziell wertvoll für die Forschung sind.