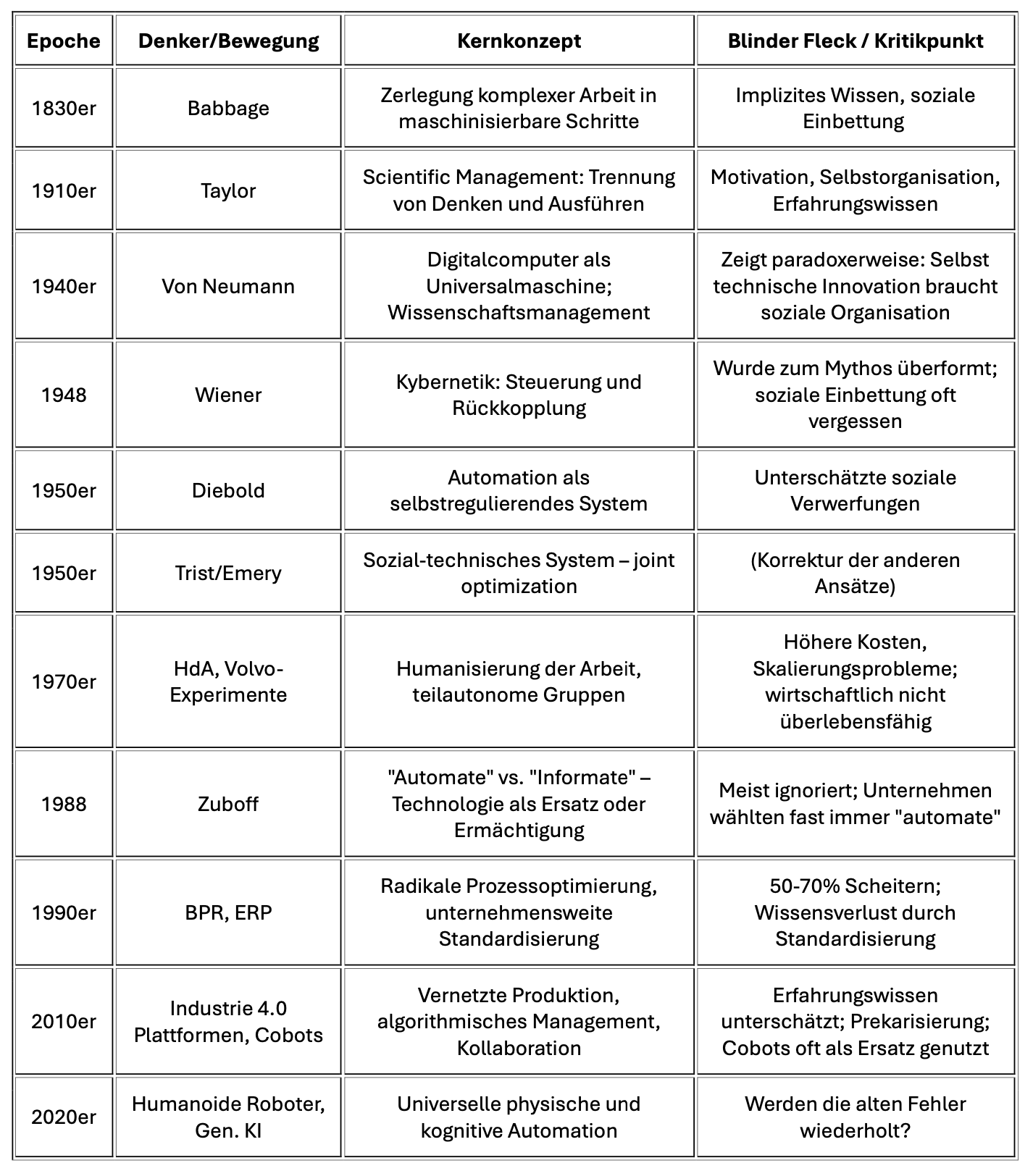

1832 formulierte Charles Babbage das Prinzip, das bis heute jede Automatisierungswelle prägt: Komplexe Arbeit in einfache Schritte zerlegen und maschinisieren. Von Taylors Scientific Management über Wieners Kybernetik, von Neumanns Computer und Diebolds Automation bis zu den ERP-Systemen der 1990er, Industrie 4.0, Cobots und humanoiden Robotern – jede Generation wiederholt denselben Fehler: Sie denkt Technologie und liefert das Soziale nach. Die Volvo-Experimente in Kalmar und Uddevalla zeigten, dass Alternativen möglich sind – und scheiterten an ökonomischen Zwängen. Shoshana Zuboff warnte 1988, dass dieselbe Technologie Menschen ersetzen oder ermächtigen kann – fast alle Unternehmen wählten Ersatz. Business Process Reengineering scheiterte zu 50–70%, weil es Organisationen als Maschinen behandelte. Heute verspricht generative KI in Verbindung mit humanoider Robotik die vollständige Substitution menschlicher Arbeit – körperlich und kognitiv. Die Tavistock-Forscher wussten schon in den 1950ern, was wir immer noch nicht beherzigen: Unternehmen sind keine Maschinen, sondern sozio-technische Systeme. Wer das ignoriert, zahlt den Preis – in gescheiterten Projekten, verlorenem Erfahrungswissen und zerstörten sozialen Strukturen.

Management Summary

Kernthese

Die Implementierung generativer KI und humanoider Roboter in Unternehmen folgt implizit einer 200 Jahre alten Logik: Arbeit in Teilschritte zerlegen, die einfachen automatisieren, Effizienz maximieren. Diese Logik – von Babbage 1832 formuliert, von Taylor systematisiert, von Wiener kybernetisch fundiert, von Diebold auf selbstregulierende Systeme erweitert – hat einen systematischen blinden Fleck: Sie behandelt Organisationen als technische Systeme und übersieht, dass sie immer auch soziale Systeme sind.

Die Tavistock-Schule zeigte bereits vor 70 Jahren: Rein technische Optimierung zerstört oft genau die sozialen Strukturen, die Organisationen funktionsfähig machen. Die Volvo-Experimente bewiesen, dass Alternativen möglich sind – und scheiterten an ökonomischen Zwängen. Shoshana Zuboff warnte 1988, dass Technologie Menschen ersetzen oder ermächtigen kann – fast alle Unternehmen wählten Ersatz. BPR scheiterte zu 50–70%, ERP-Einführungen verfehlten ihre Ziele, Industrie 4.0 unterschätzt das Erfahrungswissen.

Generative KI wiederholt dieses Muster – nur greift sie tiefer ein als jede Technologie zuvor, weil sie nicht Muskelkraft oder strukturierte Routinen, sondern unstrukturierte kognitive Arbeit substituiert. In Verbindung mit humanoider Robotik entsteht erstmals die technische Möglichkeit vollständiger Substitution – körperlich und geistig. Die Frage, die sich seit den Kybernetikern der 1950er Jahre stellt, kehrt mit neuer Dringlichkeit zurück: Was bleibt dem Menschen?

Zentrale Einsichten

Das Babbage-Prinzip lebt weiter

Die Logik hinter KI-Workflows ist dieselbe wie vor 200 Jahren: Komplexe Arbeit in Teilaufgaben zerlegen, die einfachen maschinell erledigen, nur für die wirklich anspruchsvollen Menschen einsetzen. Was Babbage für körperliche Arbeit formulierte, wird heute auf kognitive Arbeit angewandt.

Selbst technische Innovation ist ein sozialer Prozess

John von Neumann, der Architekt des modernen Computers, war nicht nur Mathematiker, sondern vor allem ein begnadeter Wissenschaftsmanager. Er brachte Theoretiker, Ingenieure und Praktiker zusammen und übersetzte zwischen ihren Welten. Der Digitalcomputer – die Grundlage aller späteren Automatisierung – entstand nicht aus reiner Theorie, sondern aus einem hochgradig sozialen Prozess der Zusammenarbeit.

Die Ironie: Die Maschine, die später menschliche Arbeit automatisieren sollte, war selbst das Produkt unautomatisierbarer menschlicher Kooperation.

Rückkopplung ist fundamental – aber nicht ausreichend

Norbert Wieners Kybernetik lieferte das Konzept der Feedback-Schleife: Systeme, die ihren Output messen und ihr Verhalten entsprechend anpassen. Dieses Konzept ist grundlegend für jede Form von Automation. Aber die Kybernetik zeigt auch die Grenzen: Die Parallele zwischen Maschine und Organismus ist begrenzt. Lebende Systeme – und Organisationen sind lebende Systeme – funktionieren anders als Thermostate. Die Kybernetik wurde zudem zum Mythos überformt, der mehr versprach, als die Technik halten konnte. Ähnliches geschieht heute mit “Künstlicher Intelligenz”.

Diebolds Warnungen wurden ignoriert

John Diebold, der den Begriff “Automation” prägte, warnte bereits in den 1950ern: Die technische Implementierung ist das Einfache – die organisatorische und soziale Anpassung das Schwierige. Ohne bewusste Gestaltung führt Automatisierung zu Verwerfungen, die den technischen Nutzen aufzehren. Diese Warnung ist heute aktueller denn je.

Organisationen sind keine Maschinen

Die Tavistock-Forscher zeigten in den britischen Kohlebergwerken: Rein technische Optimierung zerstörte die gewachsenen sozialen Strukturen der Arbeiterteams – und damit Produktivität, Sicherheit und Arbeitszufriedenheit. Das Konzept des sozio-technischen Systems war geboren: Technik und soziales Gefüge müssen gemeinsam gestaltet werden.

Automate vs. Informate: Die vergessene Wahl

Shoshana Zuboff zeigte 1988: Dieselbe Technologie kann Arbeit ersetzen (“automate”) oder Menschen ermächtigen (“informate”). Die Wahl ist nicht technisch determiniert, sondern eine Managemententscheidung. Aber fast alle Unternehmen wählten “automate” – und verspielten das eigentliche Potential der Technologie. Diese Wahl steht bei generativer KI erneut an.

Die Geschichte wiederholt sich – mit steigenden Einsätzen

Von BPR (50–70% Scheitern) über ERP-Einführungen bis Industrie 4.0: Jede Automatisierungswelle versprach Transformation, unterschätzte das Soziale und produzierte mehr Schwierigkeiten als erwartet. Die Probleme wurden als Implementierungsfehler gedeutet, nicht als Designfehler. Dann kam die nächste Welle – und der Zyklus begann von vorn.

Generative KI greift tiefer ein als frühere Technologien

Bisherige Automatisierung substituierte körperliche Arbeit oder strukturierte kognitive Routinen (Rechnen, Datenverarbeitung). Generative KI substituiert erstmals unstrukturierte kognitive Arbeit: Texte verfassen, Situationen einschätzen, kommunizieren. Damit greift sie in das Herz des sozialen Systems ein.

Körper und Geist: Die Konvergenz von Robotik und KI

Humanoide Roboter und generative KI zielen beide auf Universalität: Das LLM soll alle sprachlichen Aufgaben übernehmen, der humanoide Roboter alle körperlichen. Die Kombination – etwa bei Figure AI – verspricht die vollständige Substitution menschlicher Arbeit. Die Fragen, die Kybernetiker in den 1950ern und Automatisierungskritiker in den 1960ern stellten, kehren mit neuer Dringlichkeit zurück: Was bleibt dem Menschen, wenn Maschinen sowohl denken als auch handeln können?

Das soziale System lässt sich nicht wegautomatisieren

Auch mit generativer KI bleiben Unternehmen sozio-technische Systeme. Die Technik ändert sich, aber die Grundstruktur nicht: Menschen kommunizieren, entwickeln Vertrauen, teilen implizites Wissen, regulieren Konflikte, improvisieren bei Unvorhergesehenem. All das lässt sich nicht in Workflows gießen.

Handlungsempfehlungen

Joint Optimization praktizieren

Technische und soziale Veränderungen gemeinsam planen, nicht nacheinander. Vor jeder KI- oder Automatisierungseinführung fragen: Welche sozialen Strukturen hängen an den betroffenen Prozessen? Was geht möglicherweise verloren?

Automate vs. Informate bewusst entscheiden

Dieselbe Technologie kann ersetzen oder ermächtigen. Die Wahl ist nicht technisch determiniert. Generative KI kann Texte automatisch produzieren – oder Menschen dabei unterstützen, bessere Texte zu schreiben. Beides ist möglich; das Zweite ist meist klüger.

Erfahrungsräume erhalten

Autonome Systeme wie XPlanar oder KI-Workflows reduzieren die Gelegenheiten, bei denen Menschen Erfahrungswissen aufbauen. Bewusst Räume schaffen, in denen Menschen weiterhin praktisch arbeiten, Fehler diagnostizieren, improvisieren können. Sonst fehlt in zehn Jahren das Wissen, um Probleme zu lösen

Autonomie statt Überwachung

Menschen brauchen Entscheidungsspielräume, nicht nur Überwachungsfunktionen. Cobots können kollaborativ eingesetzt werden – oder als billigere Roboter, die Menschen ersetzen. Die Wahl prägt, welche Fähigkeiten erhalten bleiben.

Die Generationenfrage stellen

Wer wird die Systeme in zehn Jahren noch verstehen? Wenn erfahrene Mitarbeiter in Rente gehen und Jüngere nur noch überwacht haben, entsteht eine Wissenslücke, die keine Dokumentation füllen kann.

Aus dem Scheitern lernen

BPR, ERP-Einführungen, Volvo-Experimente – die Geschichte ist voll von Lehren. Warum scheitern 50–70% der großen IT-Projekte? Nicht an der Technik, sondern am Ignorieren des Sozialen. Diese Fehler nicht mit mächtigerer Technologie wiederholen.

Ökonomische Zwänge anerkennen

Humane Alternativen scheitern oft nicht an fehlendem Wissen, sondern an Kostendruck und kurzfristigem Ergebniszwang. Wer sozio-technische Gestaltung ernst nimmt, muss auch über Wirtschaftsstrukturen reden – nicht nur über Arbeitsorganisation.

Die Konvergenzfrage stellen

Wenn generative KI und humanoide Robotik zusammenwachsen, entsteht die technische Möglichkeit vollständiger Substitution. Das erfordert eine gesellschaftliche Debatte, die über einzelne Unternehmen hinausgeht: Was bleibt dem Menschen? Wovon leben die Ersetzten? Wer entscheidet?

I. Charles Babbage und die Geburt der Maschinenökonomie

Charles Babbage ist heute vor allem als Erfinder der “Analytical Engine” bekannt, eines mechanischen Vorläufers des Computers. Für die Geschichte der Automatisierung ist jedoch sein ökonomisches Werk relevanter: “On the Economy of Machinery and Manufactures” von 1832.

Das Babbage-Prinzip

Babbage beobachtete die Manufakturen seiner Zeit und formulierte ein Prinzip, das bis heute die Logik der Rationalisierung prägt: Komplexe Arbeit sollte in Teilaufgaben unterschiedlicher Schwierigkeit zerlegt werden. So kann man für einfache Aufgaben weniger qualifizierte – und damit billigere – Arbeitskräfte einsetzen. Nur für die wirklich anspruchsvollen Schritte braucht man teure Spezialisten.

Das klingt banal, war aber revolutionär. Babbage dachte Arbeit nicht mehr als Einheit, sondern als zerlegbares System. Ein Uhrmacher, der eine komplette Uhr fertigt, muss alle Arbeitsschrit…