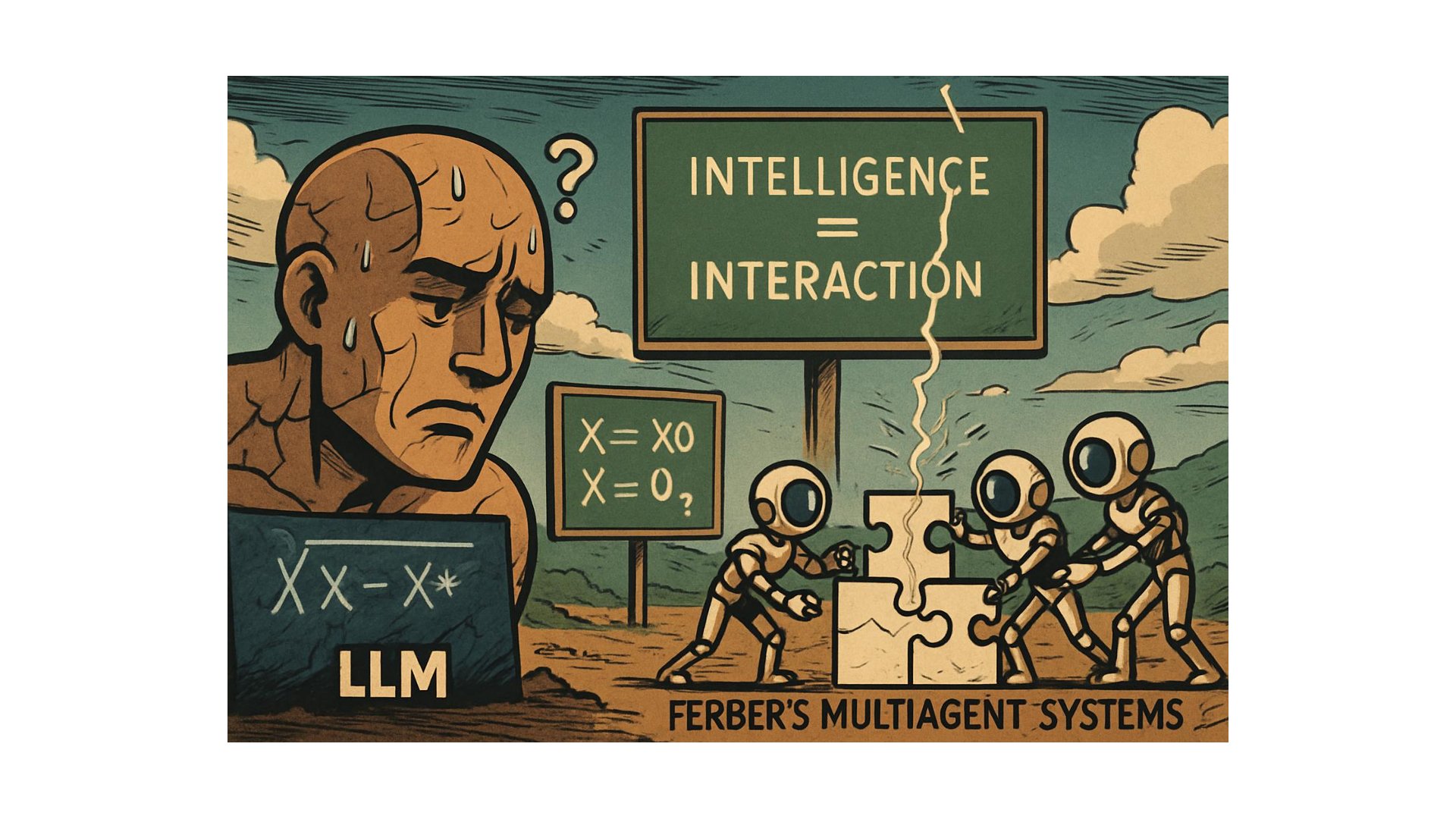

Vor dreißig Jahren formulierte ein französischer Informatiker die These, dass Intelligenz aus Interaktion emergiert – nicht aus individueller Kapazität. Die KI-Industrie ignorierte ihn, feierte den monolithischen »Denker« und musste nun feststellen: Ferber hatte recht. Die Geschichte einer theoretischen Rehabilitierung.

I. Die Ironie des Fortschritts

Es gibt Momente in der Wissenschaftsgeschichte, in denen sich Paradigmen mit einer Vehemenz durchsetzen, die jeden Widerspruch erstickt. Der Triumph der großen Sprachmodelle – GPT, Claude, Gemini – war ein solcher Moment. Hier schien sich zu manifestieren, was die klassische KI-Forschung immer erhofft hatte: Intelligenz als skalierbare Eigenschaft einzelner Systeme, implementiert in monumentalen Architekturen mit Hunderten Milliarden Parametern.

Die Ironie dabei: Dieser Triumph rehabilitierte exakt jenes Paradigma des isolierten »Denkers«, das Jacques Ferber bereits Mitte der 1990er Jahre als konzeptuelle Sackgasse identifiziert hatte. In seinem Werk über Multiagentensysteme – das französische Original erschien 1995, die englische Übersetzung 1999 – formulierte der Montpellierer Informatiker eine fundamentale Kritik, die sich gegen die gesamte Tradition der symbolischen KI richtete.

Ferbers Kernthese: Intelligenz ist keine individuelle, vom sozialen Kontext ablösbare Eigenschaft. Sie emergiert aus Interaktion. Der Versuch, »Denker« zu konstruieren, die in ihren eigenen Welten eingeschlossen operieren, verkennt die fundamentale Sozialität kognitiver Prozesse. Was wir Intelligenz nennen, wird maßgeblich durch Interaktionen mit der Umwelt geprägt – nicht durch isolierte Verarbeitungskapazität.

Die Geschichte der künstlichen Intelligenz schien diese These zu widerlegen. Dann kam 2024.

II. Die Grenzen des Monolithen

Was die Industrie in den vergangenen zwei Jahren lernen musste, liest sich wie eine nachträgliche Bestätigung von Ferbers Diagnose. Die großen Sprachmodelle, so beeindruckend ihre Fähigkeiten in isolierten Aufgaben auch sein mögen, stoßen bei komplexen, mehrstufigen Problemlösungen an systematische Grenzen.

Kontextbeschränkungen limitieren die Fähigkeit zur Informationsverfolgung über längere Interaktionen hinweg. Langzeitplanungsschwierigkeiten entstehen bei der Anpassung an unerwartete Probleme. Knowledge Drift führt zur Verstärkung und Fortpflanzung von Fehlern. Anders als Menschen, die Informationen natürlich filtern, zeigen große Sprachmodelle eine Tendenz zur kognitiven Verzerrungsverstärkung – sie amplifizieren Fehler, anstatt sie zu korrigieren.

Diese Probleme – begrenzte Kontextfenster, mangelnde Planungsfähigkeit, Halluzinationen – zwingen die Industrie zurück zu verteilten Architekturen. Die Forschung exploriert zunehmend horizo…