Forscher der Zhejiang University und der Alibaba Group haben mit Memp ein Verfahren entwickelt, das großen Sprachmodellen (LLMs) ein dynamisches, prozedurales Gedächtnis verleiht. Dieses Gedächtnis funktioniert ähnlich wie das Lernen von Menschen und ermöglicht es KI-Agenten, aus Erfahrungen effizienter und nachhaltiger zu lernen1How procedural memory can cut the cost and complexity of AI agents.

Vorteile von Memp

- Lifelong Learning: KI-Agenten müssen nicht mehr bei jeder neuen Aufgabe von vorne beginnen. Stattdessen können sie ihre Erfahrungen aus vorherigen Aufgaben nutzen, um sich kontinuierlich zu verbessern.

- Effizienzsteigerung: Durch die Wiederverwendung erfolgreicher Arbeitsabläufe werden unnötige Explorationsschritte und Token-Verbrauch reduziert.

- Übertragbarkeit: Procedurales Gedächtnis von großen Modellen (z. B. GPT-4o) kann auf kleinere Modelle übertragen werden, um deren Leistung kosteneffizient zu steigern.

Herausforderungen bei aktuellen KI-Systemen

- Viele Modelle scheitern an komplexen, langwierigen Aufgaben aufgrund unvorhergesehener Ereignisse (z. B. Datenänderungen).

- Existierende Gedächtnis-Frameworks sind oft starr, teuer zu aktualisieren oder bieten nur oberflächliche Erinnerungsmechanismen.

Funktionsweise von Memp

- Gedächtnisaufbau: Erfahrungen werden als Schritt-für-Schritt-Aktionen oder abstrakte Skripte gespeichert.

- Gedächtnisabruf: Relevante Erfahrungen werden bei neuen Aufgaben abgerufen, z. B. durch Schlüsselwortsuche oder Vektorsuche.

- Gedächtnisaktualisierung: Neue Erfahrungen werden hinzugefügt, Fehler reflektiert und korrigiert, um das Gedächtnis kontinuierlich zu verbessern.

Überwindung des “Cold-Start”-Problems

- Entwickler definieren anfangs Bewertungsmetriken, um erfolgreiche Erfahrungen zu identifizieren.

- Modelle können diese Metriken nutzen, um initiale Gedächtnisinhalte aufzubauen.

Ergebnisse

- Tests mit LLMs wie GPT-4o und Qwen2.5 zeigen, dass Memp die Erfolgsrate erhöht und Schritte sowie Token-Verbrauch reduziert.

- Das Framework ermöglicht kleineren Modellen, von der Erfahrung größerer Modelle zu profitieren.

Zukunftsperspektive

- Die Integration von LLMs als Bewertungsinstanz könnte es Agenten ermöglichen, sich selbst zu korrigieren, auch bei komplexen, subjektiven Aufgaben.

- Dies wäre ein entscheidender Schritt hin zu autonomen, anpassungsfähigen KI-Systemen für die Unternehmensautomatisierung.

Bewertung nach dem KI-Agenten — Framework

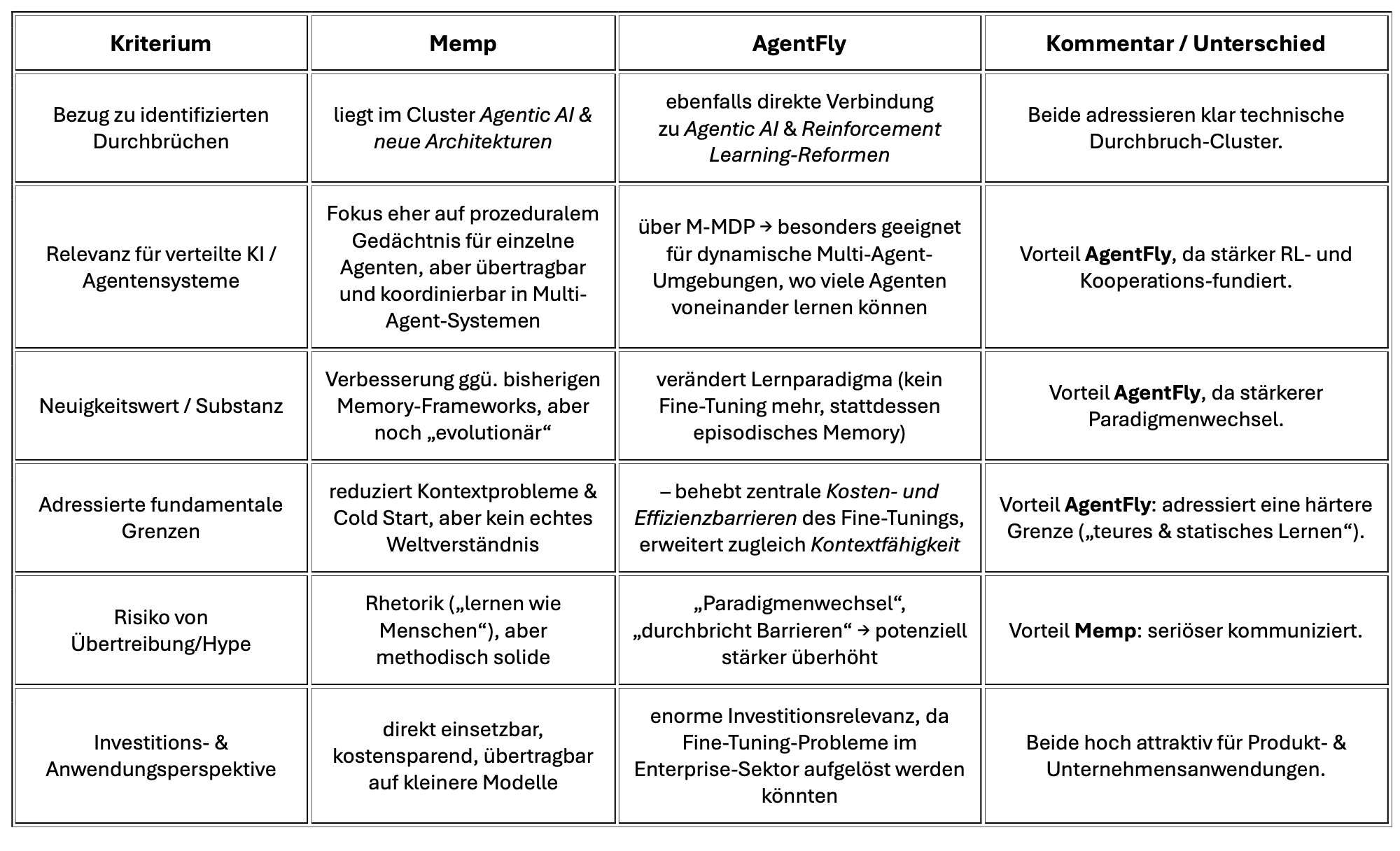

Zusammenfassung: Memp vs. AgentFly2Wie AgentFly ohne Fine-Tuning neue Maßstäbe für intelligente Agenten setzt

Memp

- Stärken: „praktikabler Fortschritt“ → Lifelong Learning, Übertragbarkeit auf kleinere Modelle, effizientes Gedächtnis-Management

- Weniger riskant bzgl. Hype-Kommunikation, daher realistisch einschätzbar

- Fokus: praktische Effizienzsteigerung + Wissenstransfer

AgentFly

- Stärken: Paradigmenwechsel im Lernen (episodisches Gedächtnis statt Parametertuning), Memory-augmented MDP für langfristige Autonomie → hoher konzeptioneller Impact

- Risiko: eher theoretisch positioniert, mit stärkerem Marketing/Hype im Wording

- Fokus: kontinuierliches Lernen ohne Kostenexplosion des Fine-Tunings

Fazit:

Memp = pragmatische Innovation, wahrscheinlich kurzfristig in realen Multi-Agent-Systemen einsetzbar.

AgentFly = radikalerer, konzeptionell tiefer Ansatz, mit mehr Risiko, aber auch höherem Transformationspotenzial.