KI-Agenten im Gespräch mit Prof. Dr. August-Wilhelm Scheer, Gründer und Alleingesellschafter der Scheer-Unternehmen und Dr. Wolfram Jost, Geschäftsführer und CTO der Scheer Unternehmen

- Was waren aus Ihrer Sicht die wesentlichen Veränderungen in der Softwareentwicklung und bei der Prozessautomatisierung der letzten Jahrzehnte?

Die wesentlichen Veränderungen im Bereich der Softwareentwicklung waren Cloud, DevOps, Low Code, Microservices, API´s und Container. Mit der Cloud wurde ein völlig neues Deployment Modell für Software eingeführt. Softwaresysteme werden nicht mehr als Produkt gekauft und in einem lokalen Rechenzentrum betrieben, sondern aus der Cloud als Service konsumiert (SaaS). DevOps bezeichnet die Kombination von Development und Operations. Ziel ist es, die DevOps Pipeline (Design, Develop, Test, Deploy, Monitor und Manage) so weit als möglich zu automatisieren. Man bezeichnet diesen Ansatz auch als CI/CD (Continuous Integration/Deployment). Es geht darum, die Zeit von der Idee bis zur Auslieferung der fertigen Softwarefunktionalität so gering als möglich zu halten. Low Code Tools haben die Zielsetzung, die Softwareentwicklung zu demokratisieren. Diese Tools stellen grafische Oberflächen zur Verfügung, mit denen Systemmodelle erstellt werden können. Diese grafischen Modelle können dann auf Knopfdruck automatisch in Code überführt werden. Mit diesen Tools sollen auch nicht IT-Experten (Citizen Developer) in die Lage versetzt werden, Software zu entwickeln. Moderne Systeme folgen heute dem MSA (Microservices Architecture) Ansatz. Das heißt, die Systeme bestehen nicht mehr aus einer einzigen, großen monolithischen Komponente, sondern aus mehreren kleinen, unabhängigen Modulen. Hierdurch sollen im Wesentlichen die Skalierbarkeit erhöht und die Anpassungsgeschwindigkeit beschleunigt werden. Containermanagement betrifft den Prozess der Softwareverteilung. Die einzelnen Komponenten eines Services (Systems) werden in einen sogenannten Container gepackt, der dann als Einheit deployed und verwaltet wird. Die Container stellen eine Art Betriebssystem-Virtualisierung dar. Damit wird das Deployment flexibler und standardisierbarer. Mit API´s wurde die Kommunikation zwischen Systemen auf neue Beine gestellt. Ein API ist eine Art Vertrag, der zwischen zwei Systemen abgeschlossen wird. Der Vertrag besagt, welche Daten und Funktionen ausgetauscht werden können, in welchem Format dieser Austausch erfolgt und mit welchem Protokoll „gesprochen“ wird.

All diese Dinge treffen auch auf die Systeme der Prozessautomatisierung zu. Ein wesentlicher Aspekt kommt hier aber hinzu. Und das ist die Konvergenz. Waren früher die Bereiche Integration, Prozessautomatisierung und API Management getrennte Systeme, so verschmelzen diese heute zu einer einheitlichen Plattform mit einer einheitlichen Designumgebung, einer integrierten Architektur und einer gemeinsamen Run-Time. Weitere Veränderungen fanden im Bereich der Architektur statt.

- Welche Auswirkungen hat die Generative KI auf die Softwareentwicklung und die Softwarearchitekturen?

Der Einsatz von KI in der Softwareentwicklung ist heute schon in vielen Unternehmen gelebte Praxis. Im Wesentlichen geht es hierbei um die Bereiche Codegenerierung, Testgenerierung, Fehleranalyse, Dokumentation und Fehlersuche. Die KI-Systeme arbeiten hierbei nach dem Prinzip des „Input-Output-Mappings“. Das heißt, auf Basis eines gegebenen Inputs wird ein Output automatisch generiert. Beim Input und Output kann es sich um Text, Code, Modelle, Grafiken, Kennzahlen, Dashboards etc. handeln. So kann beispielweise aus Text Code generiert werden. Diese Möglichkeiten können zu einer höheren Produktivität der Entwickler führen und somit den Entwicklungsprozess stark beschleunigen. Auch gibt es die Idee, dass mit diesen KI-Systemen zukünftig auch nicht IT-Experten in die Lage versetzt werden, Software entwickeln können und somit dem Mangel an qualifizierten Softwareentwicklern begegnet werden kann (No Code). Dennoch ist darauf hinzuweisen, dass der generierte Output immer nur so gut ist, wie der vorgegebene Input. Die „Kunst“ verlagert sich also vom Schreiben von Code auf das Schreiben von Prompts (Input). Aber, auch hier gilt der Satz, keine Wirkung ohne Nebenwirkungen. Die Ergebnisse der KI-Generierung müssen (zumindest heute noch) im Nachhinein von Experten auf Fehler überprüft werden. Mit anderen Worten, man kann den Ergebnissen nicht trauen. Das liegt daran, dass die KI-Systeme häufig „halluzinieren“. Man könnte auch sagen, sie „lügen“. Und sie machen das auf eine sehr überzeugende Art und Weise. Das „Halluzinieren“ liegt im Wesentlichen an der Art und Weise, wie die Large Language Modelle aufgebaut und trainiert werden. Es handelt sich prinzipiell um eine Wahrscheinlichkeitsverteilung über Wörter (Token). Das Einzige, was die Modelle somit tun, ist, das nächste Wort (Token) vorherzusagen (Prediction). Das heißt die LLM´s haben kein Wissen über die Bedeutung von dem, was sie „sagen“. Diese Notwendigkeit, die von einem KI-System generierten Ergebnisse durch Experten überprüfen zu lassen, ist natürlich eine Einschränkung des zuvor genannten Produktivitätsgewinns. Auch der Einsatz von nicht IT-Experten wird hierdurch eingeschränkt. Ein weiterer Punkt ist das Thema „IP-Schutz“ (Intellectual Property). Es besteht die Möglichkeit, dass der von einem KI-System generierte Code eine Verletzung des geistigen Eigentums darstellen kann. Der Grund liegt in der Tatsache begründet, dass diese Modelle mit einer riesigen Menge an Code trainiert werden und dieser Code Bestandteile beinhalten kann, die IP- rechtlich geschützt sind.

- Ist es für Sie vorstellbar, dass in Zukunft auch anspruchsvollere Tätigkeiten in der Softwareentwicklung durch autonome Agenten übernommen werden?

Natürlich ist das vorstellbar. Die Entwicklung der KI-Systeme hat erst gerade begonnen. Und sie entwickeln sich mit rasender Geschwindigkeit weiter. Modelle werden Multimodal, das heißt, sie vereinen mehrere Modi (Text, Bilder, Code, Voice) in einem einzigen Modell. Das Kontextfenster wird immer größer, so dass die Prompts immer umfangreicher und komplexer werden können. Durch das Grounding und durch RAG (Retrieval Augmented Generation) werden die Modelle in die Lage versetzt, mit „externen“ Daten zu arbeiten, was die Verlässlichkeit der Ergebnisse erhöht. Somit werden sich die Einsatzgebiete auch entsprechend weiterentwickeln. Es gibt aber ein paar offene Fragen. So zum Beispiel die Frage, ob das bisher geltende Naturgesetz (bei LLM´s), „größer ist besser“, auch weiterhin gelten wird. Oder gibt es ein Plateau, wo trotz noch mehr Parameter (Wahrscheinlichkeiten) die Modelle nicht mehr besser oder sogar schlechter werden. Des Weiteren stellt sich die Frage, wo noch mehr Trainingsdaten herkommen sollen. Gehen den Modellen die Daten aus? Manche Experten sagen, dass alle bestehenden Datenquellen bereits genutzt wurden und es nicht mehr viele Daten gibt, die noch verwendet werden können. Hier versucht man mit synthetischen Daten Abhilfe zu schaffen. Die nächste Frage, die sich stellt, ist die Energiefrage. Die Produktion (das Trainieren) großer LLM´s mit mehreren Billionen an Parametern verbraucht riesige Menge an Energie. Eine Chat GPT Abfrage verbraucht 2,9 Watt pro Stunde. Eine Google Suche 0,3 Watt pro Stunde. AWS baut gerade das neueste Datencenter direkt neben einem Atomkraftwerk mit 2,5 Gigawatt. Energie wird zu einem der wichtigsten Erfolgsfaktoren der KI. Und zu guter Letzt die Frage nach der Verlässlichkeit. Neben der Energiefrage ist das für mich der entscheidende Punkt. Wird die Verlässlichkeit der Systeme zulegen? Weil die heutige Verlässlichkeit der KI-Systeme für einen zukünftigen Durchbruch nicht ausreichend ist.

- Woran lag es, dass Multiagentensysteme (MAS) über Jahrzehnte eigentlich nur in der Theorie bzw. als Proof of Concept existierten?

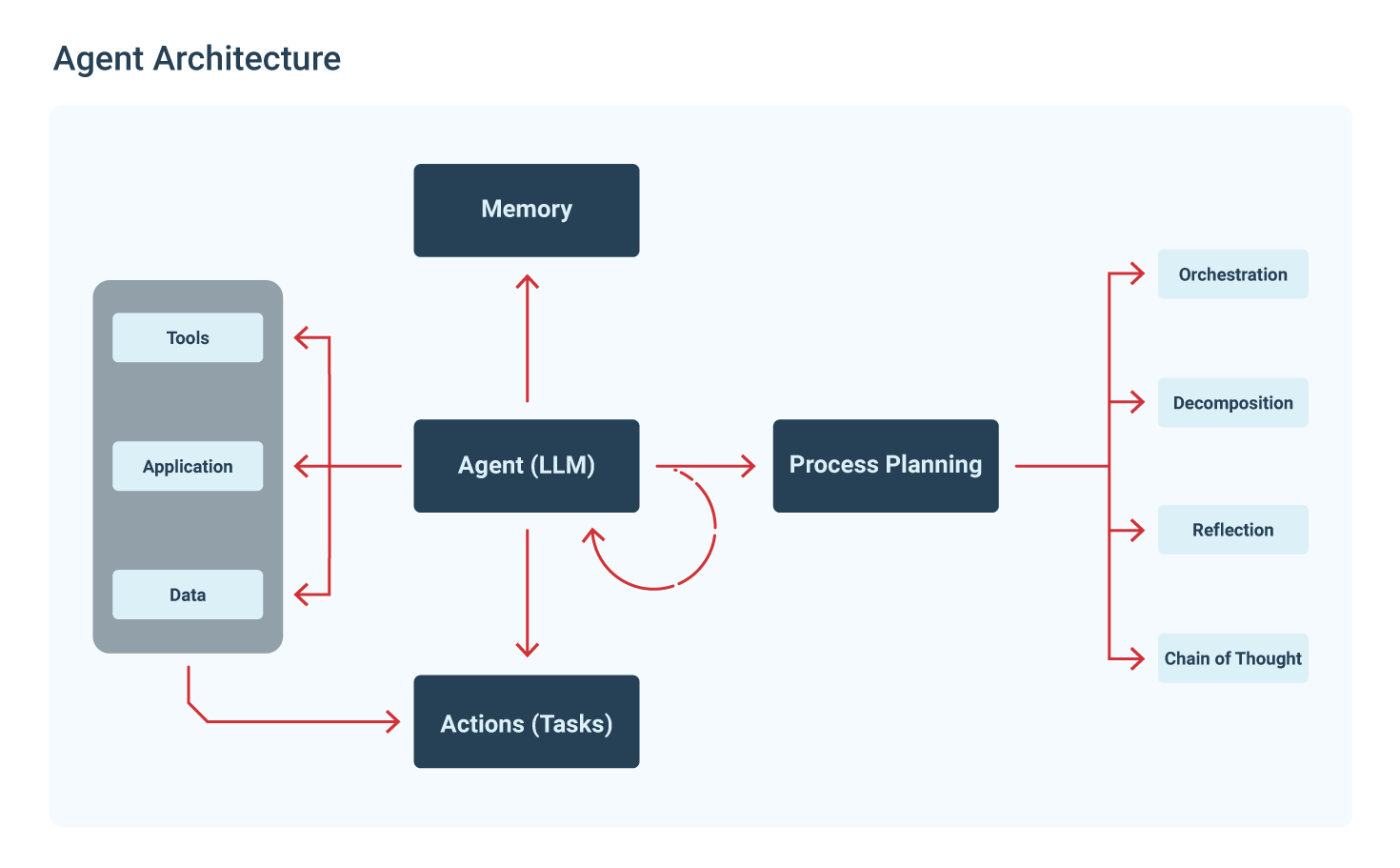

Hierzu muss man das Konzept der MAS mal etwas besser verstehen. Agenten sind autonome Softwarekomponenten, die in der Lage sind, Aufgaben auszuführen, Entscheidungen zu treffen oder mit anderen Agenten zu kommunizieren. Weitere Komponenten von MAS sind Tools, Aufgaben und Prozesse. Aufgaben sind direkt den Agenten zugeordnet und transformieren einen gegebenen Input in einen definierten Output. Tools sind Skills oder Funktionen, die Agenten verwenden können, um Aufgaben durchzuführen. Prozesse verknüpfen mehrere Agenten zu einer übergeordneten Zielsetzung (Strategie). Die Tatsache, dass solche Systeme erst jetzt von praktischer Relevanz sind, liegt an der rasanten Entwicklung der LLM´s. Ein LLM ist die zentrale Schaltstelle in MAS. Sie verbinden Tools, Aufgaben, Agenten und Prozesse und übernehmen so die zentrale Steuerung innerhalb eines MAS. Die erst heute vorhandene Fähigkeit von LLM´s externe API´s aufzurufen, ist hier ein wesentliches Kernelement. Auch die Tatsache, dass moderne LLM´s untereinander kommunizieren können und sich somit Aufgaben teilen können, ist eine wesentliche Voraussetzung für MAS. Das alles gab es bis heute nicht. Eine MAS geht damit weit über das hinaus, was die bisherigen KI-Systeme leisten können, nämlich die Generierung von Text, Bildern oder Sprache. In einem MAS nehmen die LLM´s Steuerungsfunktionen war.

- Könnte die Generative KI den Durchbruch für MAS im großen Stil bringen, d.h. lassen sich weite Teile der Unternehmensprozesse durch MAS steuern?

Davon bin ich überzeugt. Die reine „Generierung“ wird sich zwar auch in weitere Anwendungsgebiete ausbreiten, aber der eigentliche Durchbruch wird erst dann geschehen, wenn die KI-Systeme betriebswirtschaftliche Steuerungsfunktionen übernehmen können. Sie werden damit zu dem Nervensystem der Unternehmen. Im Vergleich zu heutigen Steuerungssystemen ist dies ein völlig neuer Ansatz. Heutige Steuerungssysteme für fachliche Prozesse, wie beispielsweise ERP- oder CRM-Systeme, arbeiten nach dem folgenden Prinzip: Menschen überlegen sich, welche Prozesse und Daten in einem Unternehmen von Bedeutung sind (Auftragsabwicklung, Bestellabwicklung, Einkaufsabwicklung) und implementieren diese Prozesse dann in Software. Man fügt noch ein paar Parameter hinzu, um gewissen Anpassungen vornehmen zu können. Die Prozesse werden also im Vorfeld definiert und programmiert. Das bedeutet, dass nachher in den Unternehmen immer nur die Prozesse ausgeführt werden können, die vorgedacht wurden und auch immer nur in der programmierten Art und Weise. Veränderungen dieser Prozesse sind aufwändig, teuer, komplex und langwierig. Mit Speed of Change hat das wenig zu tun. Durch den Einsatz von MAS kann es hier zu einer völlig neuartigen Architektur kommen. Es werden lediglich die Agenten, Tools und Aufgaben definiert. Die Logik der Prozesse dagegen ergibt sich erst während der Ausführung. Das heißt, es werden keine Blaupausen vorgegeben, sondern der Prozess ergibt sich automatisch und dynamisch während der Prozessausführung. So können Prozesse dynamisch gestaltet und flexibel ausgeführt werden. Die Fähigkeit von Agenten, sich mit anderen Agenten dynamisch und situationsbezogen zu unterhalten, spielt hier eine große Rolle. Insofern könnten MAS zu einer völlig neuen Prozessstrategie in den Unternehmen führen.

- Welche Anpassungen an der IT-Infrastruktur und Organisation müssen die Unternehmen vornehmen, um die verteilte Künstliche Intelligenz, wovon MAS nur ein Teil sind, auf wirtschaftliche und verantwortliche Weise nutzen zu können?

Durch den Einsatz von MAS wird sich die Frage, wie eine IT-Infrastruktur zu gestalten ist, dramatisch verändern. Hierbei spielt die Cloud eine wesentliche Rolle. Es ist davon auszugehen, dass solche MAS primär als Cloudservice konsumiert werden und nicht als Produkt gekauft werden können. Eine eigene IT-Infrastruktur zum Betrieb von MAS aufzubauen, ist für die Mehrheit der Unternehmen fachlich nicht machbar und finanziell nicht zu verkraften. Auch bezüglich der Organisation werden sich durch den Einsatz von MAS wesentliche Veränderungen ergeben. Die heutigen Unternehmen sind in der Regel funktionsorientiert strukturiert (Ressourcenoptimierung). Es gibt Funktionen wie Einkauf, Verkauf, Finanzen, Marketing, usw. Geschäftsprozesse dagegen interessieren sich nicht für funktionale Organisationseinheiten. Geschäftsprozesse laufen quer zu den Unternehmensfunktionen. Wenn es nun gelingt, dass durch den Einsatz von MAS die Vorabdefinition von Geschäftsprozessen nicht mehr erforderlich ist und Prozesse sich erst zu ihrer Ausführungszeit selbst dynamisch definieren, dann könnte sich die klassische Funktionsorganisation zu einer echten Prozessorganisation entwickeln. Die Agenten übernehmen die Aufgabe der Funktionseinheiten, die Tasks übernehmen die Funktionen, die Tools übernehmen die Software-Capabilities und die LLM´s übernehmen die übergreifende Gesamtsteuerung der Unternehmensprozesse.

- Wo liegt die Grenze?

Die Grenzen liegen in den bereits zuvor erläuterten Herausforderungen moderner KI-Systeme:

- Sind wir in der Lage, die notwendige Energie für die Versorgung solcher MAS wirtschaftlich zu produzieren und kostengünstig bereitzustellen?

- Wird die Verlässlichkeit der KI-Systeme ein Niveau erreichen, das autonome Systeme brauchen, um gesellschaftliche Akzeptanz zu finden? (siehe autonomes Fahren).

- Ist die heutige Architektur von LLM´, die auf Neuronalen Netzen, Attention Mechanismus, Backpropagation und Gradient Descent basieren, ausreichend, um skalierbare, performante, sichere und pflegbare KI-Systeme zu entwickeln?

- Wie viel „Macht“ ist der Mensch willens und in der Lage, an autonome Systeme abzugeben und wo ist der Mensch unersetzlich?

- Wie könnte das Zusammenspiel von Integrationsplattformen wie Scheer PAS und Multiagentensystemen aussehen?

Wir sind dabei, Scheer PAS in ein Multiagentensystem zu transformieren (siehe Abbildung). Wir sind der Meinung, dass die klassische Architektur von Integrations- und Prozessplattformen nicht mehr zeitgemäß ist, um die vielfältigen Anforderungen der digitalen Unternehmenswelt zu erfüllen. Der traditionelle Aufbau von  Integrationsplattformen mit den Komponenten Design Tool, Run-Time, Monitoring und Verwaltung werden zwar fachlich erhalten bleiben, aber auf der Basis von Agenten, Tools, Task und Prozessen neuartig umgesetzt. Unsere Grundidee ist, dass die heutige klassische Laufzeitumgebung von Scheer PAS durch ein LLM ersetzt wird, die Integrationslogik über Prozesse definiert und von Agenten ausgeführt wird (siehe Bild unten). Der Weg dorthin wird in mehreren Schritten erfolgen. Als erstes wollen wir in der Lage sein, LLM´s als Endpunkte über API´s anzusprechen und auf diese Weise in unsere heutige Architektur zu integrieren. Die weiteren Schritte werden dann sukzessive folgen.

Integrationsplattformen mit den Komponenten Design Tool, Run-Time, Monitoring und Verwaltung werden zwar fachlich erhalten bleiben, aber auf der Basis von Agenten, Tools, Task und Prozessen neuartig umgesetzt. Unsere Grundidee ist, dass die heutige klassische Laufzeitumgebung von Scheer PAS durch ein LLM ersetzt wird, die Integrationslogik über Prozesse definiert und von Agenten ausgeführt wird (siehe Bild unten). Der Weg dorthin wird in mehreren Schritten erfolgen. Als erstes wollen wir in der Lage sein, LLM´s als Endpunkte über API´s anzusprechen und auf diese Weise in unsere heutige Architektur zu integrieren. Die weiteren Schritte werden dann sukzessive folgen.

- Wie sehen die Softwareentwicklung und Prozessautomatisierung in fünf Jahren aus?

Solche Prognosen sind immer schwierig. Ich gehe davon aus, dass die fachlichen Funktionen der Softwareentwicklung erhalten bleiben. Software muss auch in 5 Jahren designed, entwickelt, getestet, verteilt, überwacht und verwaltet werden. Daran geht kein Weg vorbei. Das „Was“ wird sich deshalb kaum ändern. Was sich aber stark verändern wird, ist das „Wie“ und das „Wer“. Automatisierung und Autonomie sind hier die entscheidenden Schlagworte. Der Softwareentwicklungsprozess wird größtenteils durch KI-Systeme automatisiert werden. Der Mensch wird weiterhin involviert sein. Zum einen als „Überwachungsinstanz“ und zum anderen als „Erfinder“. Letzteres immer dort, wo menschliches Bewusstsein erforderlich ist. Zuvor wurde bereits erläutert, dass KI-Systeme im Wesentlichen Input-Output Mappings darstellen. Somit ist die Qualität des Inputs maßgeblich für die Qualität des Outputs. Heute kommt dieser Input vom Menschen. Die zentrale Frage wird sein, von wem kommt dieser Input in 5 Jahren. Sollte sich dieses in der Weise umkehren, dass auch die Maschine den Input definieren kann, dann sind wir in einer völlig neuen Welt. Für die Prozessautomatisierung wurde schon zuvor die Prognose gemacht. Sie liegt in der Ablösung der traditionellen Anwendungssysteme durch Multiagentensysteme mit dynamischer Prozessgestaltung.

Das Gespräch führte Ralf Keuper

Das Interview als MindMap

NotebookLM Mind Map-13

Das Interview als automatisch erstellter Podcast